基于分布式光交换高带宽域InfiniteHBD:破局超节点扩展瓶颈

发布时间:2025-06-05

随着大模型参数规模的扩大,分布式训练成为人工智能发展的核心途径。分布式训练可以将模型数据分配给多个计算节点,进行并行计算和数据管理,从而显著加速模型训练的过程,而高带宽域(High Bandwidht Domain, HBD)的设计对提升模型算力利用率至关重要。

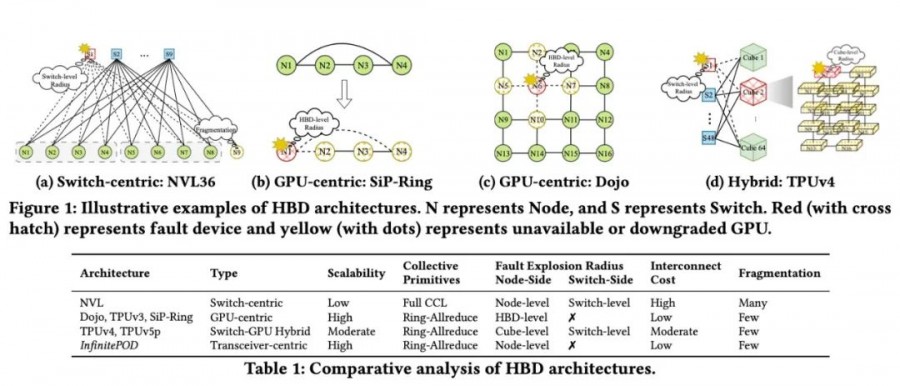

以交换机为中心的HBD(如NVIDIA NVL72)成本高昂、不易扩展规模。

以以AI 加速器(包括GPU 与专用ASIC)为中心的HBD(如Google TPUv3和Tesla Dojo)存在严重的故障传播问题。 2022 年Google发布TPU v4 集群,首次采用光交换方案(Optical Circuit Switch,以下简称“OCS”),这种交换机-GPU混合的HBD在互连成本与系统扩展性之间采取了折中方案,但仍存在故障爆炸半径问题,其成本和容错能力仍不甚理想。

InfiniteHBD在可扩展性和成本上全面优于现有方案:InfiniteHBD的单位成本仅为NVL72的31%,GPU冗余率比NVL72和TPUv4低一个数量级,且与NVIDIA DGX(单机8卡)相比,模型算力利用率最高提升3.37 倍。

该方案以论文形式被国际通信网络领域顶级会议SIGCOMM 2025接收。

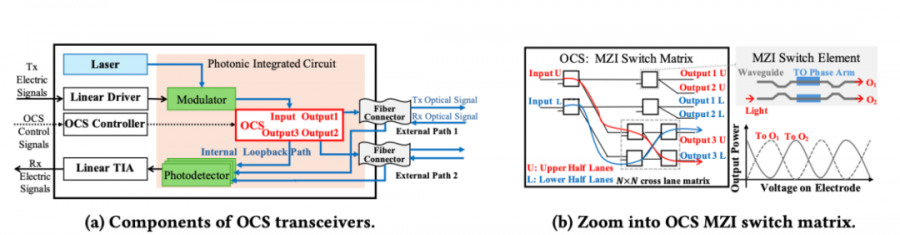

曦智科技在集成硅光领域拥有十余年的产业经验,在InfiniteHBD 方案中,创新性的开发了基于硅光子技术的分布式光交换dOCS(distributed Optical Circuit Switch),将基于马赫曾德(MZI,Mach-Zehnder Interferometer)交换矩阵的光交换芯片集成到商用QSFP-DD 800Gbps光电转换模组中,大幅简化了器件结构的同时,有效提升了器件集成度,从而降低了成本和功耗,显著提升了InfiniteHBD 的性价比和系统可扩展性。

dOCS自带光电转换,提供交换能力的同时可形成跨机超节点;

光交换芯片采用成熟制程,降低了对于先进制程电交换芯片的依赖; 光交换芯片对协议不敏感,适用于当前GPU连接协议碎片化的现状